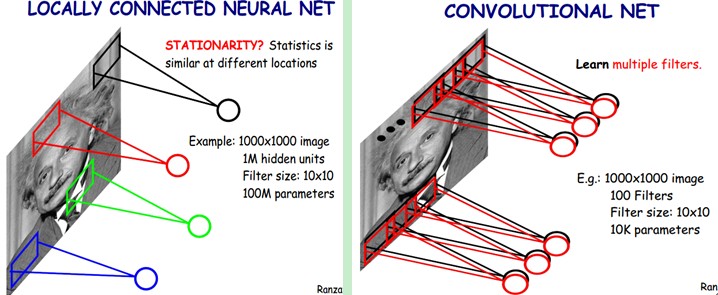

上图是CNN,卷积神经网络,经典的深度学习网络模型。

深度学习近几年真是风光无限,各大IT公司都斥巨资投入相关的研究,从事相关研究的研究员也已经不计其数,业界的大神的名字想必你也听出了茧子,深度学习从2006年一路走来发达的故事估计网上也是铺天盖地,本文就不赘述了。

本文主要探讨深度学习本身的价值和弊端。

深度学习的成功之处在于采用了分层训练机制,即逐层初始化后,再进行全局性回归迭代。而分层思想正好与人脑的分层机制保持了一致,从脑神经学的研究成果和深度学习算法的实践都让大家开始认同,分层机制是智能的核心机制之一。虽然数学上大家对于深度学习在传统机器学习领域的进步原因没有理论上的说明,但是从大的方向上,我认为这一步是对的,因为分层机制和自然界的组成模式高度吻合,充分发挥计算效率的最佳办法就是最小化表示,最大化容量。

但是,深度学习的众多弊端使得他注定还需要重大的改进或者期待更优秀的算法出现才能像真正的类人智能迈进。

第一、时序机制缺失。神经元网络是处于时间流的,亦即卷积不是只发生在空间层面,在时间轴上无时无刻不在发生,大量的卷积同时并行发生,计算量可想而知,基于时序和工作空间,配合注意力的调度,人脑才能高度协调各功能模块完成一个复杂的智能任务。而现时的深度学习还停留在时间无关的分类任务上,换句话说,就是更厉害的模式识别。模式识别不等于智能。

第二、缺失归纳推理机制。该模型目前在图像、语音识别领域有不错的进步,而作为实体、实体关系、抽象逻辑的载体,比如文字和语音承载的语句含义,音乐承载的美感,画面的风格,都缺乏有效的机制来实现。这也是DL在NLP领域的效果不好的原因,因为NLP依赖归纳推理机制,当然感同能力也很关键。此机制也可以称为联想机制。

第三、运动系统。拥有运动系统的控制能力,如摄像头的变焦转动等,可以使得自主调度注意力完成对新鲜事物的学习,这种学习是基于理解的,而不是基于数学上的回归的。理解的最终目的是建立一个有意义的复杂网络连接关系,而不仅仅是利用权重拟合,这两者有着本质的区别。

第四、更有效的层次结构。深度学习模型衍生于机器学习模型,有着极强的数学理想主义色彩,试图通过简单的模型,完成复杂的工作,而我认为这条路未必行的通,大脑结构一定有更加惊奇的设计结构,绝不是CNN这么简单,像HTM(层次化时序模型)这种探索是有意义的。

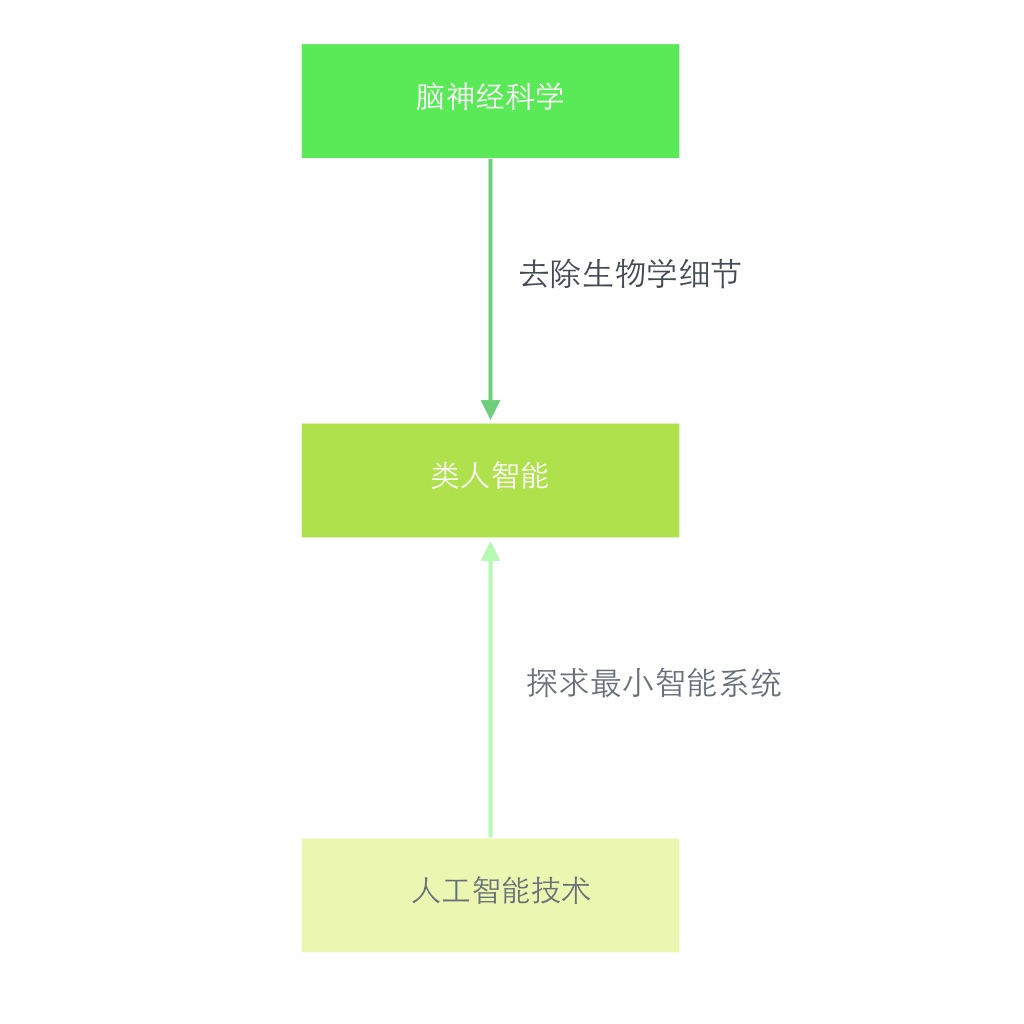

类人智能的发展路线如下图所示,两个研究方向都在朝中心点靠近。

由于大量的智力资源已经投入到这个领域,相信不远的将来最小智能系统即可实现。